- Veröffentlichung:

01.10.2025 - Lesezeit: 8 Minuten

Vom Need-To-Know zum Need-To-Share-Prinzip: Datenverfügbarkeit statt Informationssilos

Need-To-Share: Von restriktiver Kontrolle zur skalierbaren Kollaboration

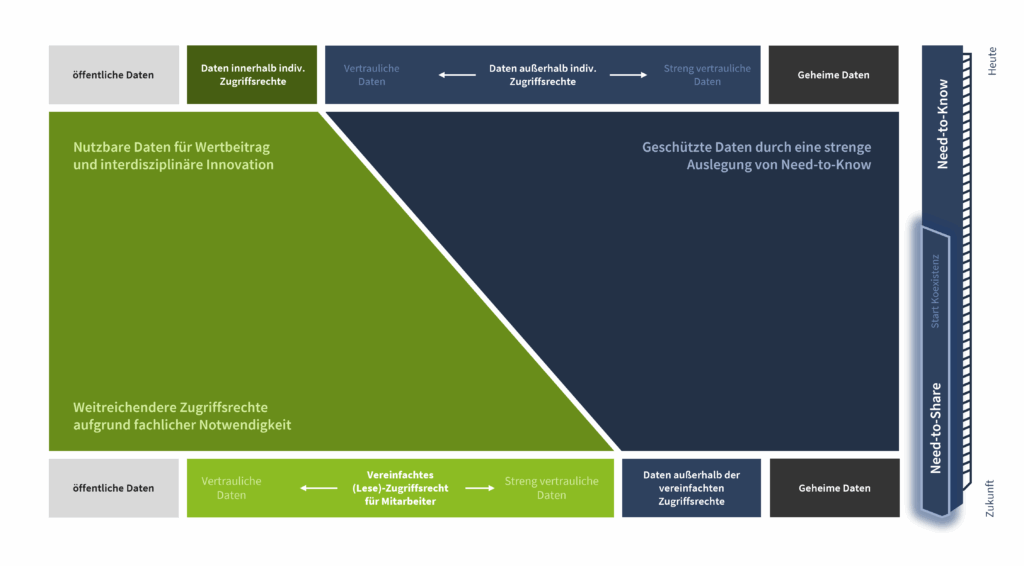

Das klassische Need-to-Know-Prinzip war über viele Jahre Garant für Datenschutz und Compliance. Inzwischen zeigt sich: Innovation, Geschwindigkeit und Effizienz leiden, wenn nur wenige Experten Zugang zu den wichtigsten Informationen haben. Unternehmen, die wachsen und wettbewerbsfähig bleiben wollen, müssen umdenken. Das bedeutet nicht blinde Öffnung, sondern eine gezielte, risiko- und nutzenbasierte Erweiterung des Datenzugriffs. Ein skalierbarer Freigabeprozess, der Transparenz und Sicherheit verbindet, wird zum Schlüsselfaktor. So entsteht ein neues Paradigma, in dem Daten dynamisch und flexibel eingesetzt werden können, um Wertschöpfung, KI-Anwendungen und Innovationen zu fördern, ohne regulatorische Anforderungen aus den Augen zu verlieren.

Bedeutung von Datentransparenz – Erfolgsfaktor für Innovation und Unternehmensresilienz

Ohne Transparenz bleibt das Potenzial selbst hochwertigster Daten oft ungenutzt. Ein zentraler Datenkatalog, der Geschäftsobjekte semantisch beschreibt, Schutzbedarfsklassifizierungen sichtbar macht und Benutzerrechte nachvollziehbar abbildet, bringt Licht ins Dunkel. Dies ermöglicht nicht nur die automatisierte Freigabe von Daten und eine schnelle Reaktion auf neue Business-Anforderungen, sondern bildet die Grundlage für KI-Anwendungen, datenbasierte Governance und effiziente Kollaboration, auch bereichsübergreifend oder mit externen Partnern. Mitarbeitende profitieren von klaren Prozessen; Führungskräfte erhalten eine neue Grundlage zur Steuerung von Wertströmen sowie Kontrolle über Compliance und Datenschutz

Herausforderungen und Lösungsansätze des Need-to-

Know-Prinzips in der heutigen Datenpraxis

Die Einführung eines zentralen, semantisch angereicherten Datenkatalogs (Business Object Repository) bildet die Basis für eine moderne, datengetriebene Organisation. Alle relevanten Geschäftsobjekte werden samt Schutzbedarfsstufen und Need-to-Share-Fähigkeit klassifiziert und sind im Katalog eindeutig referenziert. Das Mapping auf physische Schemata schafft nicht nur Übersichtlichkeit, sondern erleichtert die Wiederverwendung von Schutzbedarfsklassifikationen und fördert die Automatisierung datenbezogener Prozesse. Damit wird ein Single Point of Truth geschaffen, der sowohl für automatisierte Freigaben als auch für die KI-gerechte Auswertbarkeit unternehmensinterner Datenbasis unerlässlich ist.

Für eine skalierbare Datenfreigabe sind strukturierte Verantwortlichkeiten und eindeutige Berechtigungsmodelle essenziell. Indem die Risiko- und Freigabeprozesse organisationsweit analysiert und konsolidiert werden, entstehen eindeutige Rollen, transparente Entscheidungswege sowie einheitliche Prüfmechanismen. Überhistorisch gewachsene Engstellen, Mythen zu persönlicher Haftung und überzogene Interpretationen regulatorischer Vorgaben werden dadurch aufgelöst und die reibungslose Zusammenarbeit zwischen IT, Fachbereichen und Konzernsicherheit gezielt gefördert.

Der datenobjektbasierte Ansatz ermöglicht, Schutzbedarfsklassifikationen direkt und wiederverwendbar am Datenobjekt zu hinterlegen. Ein datenorientierter, toolgestützter Freigabeprozess beschleunigt die Freigabe insbesondere von nicht-kritischen Daten durch Automatisierung, während bei sensiblen Daten umfassende Kontextinformationen für die fundierte Risiko-Nutzen-Abwägung bereitgestellt werden. So entsteht eine effiziente, nachvollziehbare und anwendungsübergreifend nutzbare Struktur, die gerade für dynamische KI- und Analytics-Szenarien essenziell ist.

Die erfolgreichen Projekte zeigen, dass neben Regulatorik und Technologie insbesondere die Akzeptanz und das Verständnis der Mitarbeitenden transformiert werden müssen. Durch klare Kommunikationslinien, transparente Richtlinien und unternehmensweite Schulungen werden Vorbehalte gegen neue Freigabekonzepte abgebaut. Hier ist es wichtig auf die zentrale Änderung in der Datenkultur zu fokussieren. Daten dürfen nicht mehr als schützenswerter „Schatz“ einer bestimmten Stelle gesehen werden, sondern als kollektives Asset der gesamten Organisation. Eine enge Abstimmung zwischen IT, Fachbereichen und Konzernsicherheit sorgt für einen nachhaltigen Wissenstransfer und verankert einen kooperativen Umgang mit dem Rohstoff Daten als Erfolgsfaktor.

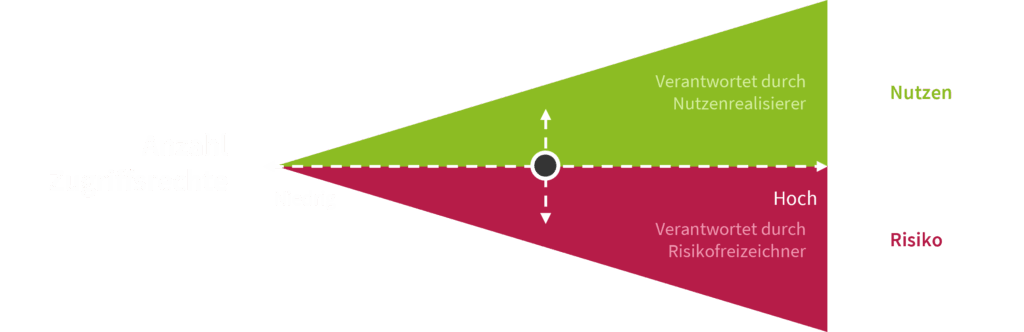

Effektive Datenfreigabe bedeutet mehr als reine Risikovermeidung: Erst wenn der Freigabeprozess explizit Chancenbewertungen integriert und Geschäftsnutzen systematisch mit potenziellen Risiken abwägt, entsteht die Basis für eine wirklich wertschöpfende Entscheidungskultur. Die unmittelbare Gegenüberstellung von Risiken und Mehrwerten im Freigabedokument ermöglicht schnelle, nachvollziehbare Entscheidungen und belegt, dass unternehmensweite Need-to-Share-Fähigkeit und Compliance keineswegs im Widerspruch stehen, sondern gemeinsam den Weg für skalierbare Dateninnovationen bereiten.

Need-to-Share als datenorientiertes, skalierbares Konzept

Das Need-to-Share-Prinzip setzt auf ein datenobjektbasiertes Modell: Schutzbedarfsklassifizierungen werden direkt und wiederverwendbar an Business Objekten gespeichert und stehen für verschiedenste Anwendungen abrufbereit. Ein semantisch angereicherter Datenkatalog macht nicht nur automatisierte Zugriffsentscheide möglich, sondern liefert auch eine unternehmensweite Daten-Ontologie. Diese Transparenz erleichtert die Bewertung von Chancen und Risiken jedes Freigabevorhabens und erlaubt die sofortige, kontextsensitive Freigabe nicht-kritischer Daten. Für sensible Daten unterstützt der Katalog einen schnellen, nachvollziehbaren Entscheidungsprozess, der Sicherheit und Mehrwert abwägt.

Skalierbarkeit & Agilität durch Need-to-Share

Unternehmen, die Need-to-Share konsequent umsetzen, erzielen eine drastische Verkürzung von Freigabezyklen und einen Effizienzsprung bei der Entwicklung digitaler Produkte. Pilotprojekte belegen: Rechte werden von Einzelpersonen auf Personengruppen ausgeweitet, der Freigabeprozess wird vielschichtiger, aber gleichzeitig schneller und transparenter. Zentrale Freigabeprozesse, etwa über ein Business Object Repository, reduzieren Doppelarbeit, liefern schnell verfügbare, konforme Daten und ermöglichen eine flexible Erweiterung auf weitere Use Cases. So kann die Organisation KI-Trainingsdaten rasch bereitstellen, neue Insights generieren und datenbasierte Innovationen innerhalb kürzester Zeit launchen.

Need-To-Know zu Need-To-Share Praxisbeispiel „Chattable Entwicklungsdaten“:

Von der Idee zur Blaupause

Governance & Regulatorik im Need-To-Share Ansatz: Effizienz durch klar definierte Strukturen

Change-Kommunikation und Mindset-Transformation: Der Erfolgsfaktor für den Rollout von Need-To-Share

Fazit

Ihr Ansprechpartner

Jetzt unverbindliches Erstgespräch vereinbaren

- Expertise: Transformation fragmentierter Datenlandschaften in skalierbare, miteinander vernetzte Ökosysteme

- Transparenz: Aufbau nachvollziehbarer Strukturen für Steuerung, Freigabe und Compliance im Datenmanagement

- Effizienz: Beschleunigung von Wertschöpfungsprozessen durch Automatisierung und optimierte Datenbereitstellung

- Nachhaltigkeit: Verankerung eines unternehmensweiten Daten-Mindsets für dauerhafte Innovations- und Wettbewerbsfähigkeit

TISAX und ISO-Zertifizierung nur für den Standort in München

Ihre Nachricht